9月10日消息,除了宣布专门用于大规模上下文处理的Rubin CPX,NVIDIA还同时披露了新一代AI服务器,规模和性能实现了大幅度的跃升。

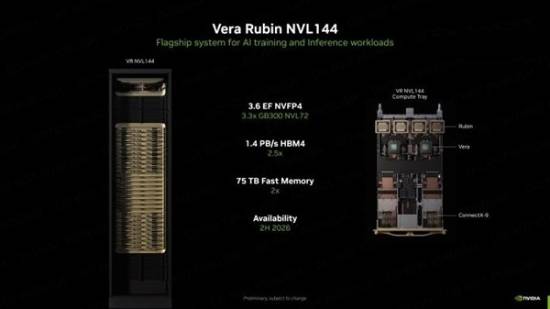

“Vera Rubin NVL144”定位于AI训练与推理用途的旗舰产品,应该每个机架配备36颗Vera CPU、144颗Rubin GPU,同时搭配1.4PB/s超高带宽的HBM4(容量没说),以及多达75TB存储。

算力性能在NVFP4数据精度下可高达3.5 EFlops,也就是每秒350亿亿次,对比GB300 NVL72提升3.3倍!

“Vera Rubin NVL144 CPX”又加入了72颗Rubin CPX,组成了单个机架144颗GPU、36颗CPU的庞大规模。

同时,它还有1.7PB/s带宽的HBM4内存、100TB高速存储,以及Quantum-X800 InfiniBand或者Spectrum-X以太网,搭配ConnectX-9 NIC网卡。

整机算力在NVFP4下达到了惊人的8 EFlops,即每秒800亿亿次,对比GB300 NVL72提升了7.5倍。

如果有需要,可以将两台服务器组合在一起,配置和算力直接翻倍。

NVIDIA号称,有了这样的AI服务器,每投入1亿美元,就可以换来50亿美元的收获。

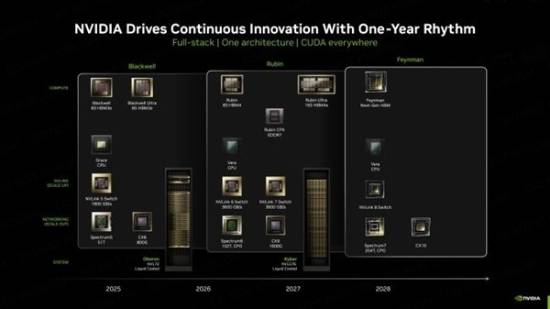

NVIDIA最新公布的路线图显示,Rubin GPU和相关系统将在2026年底开始登场,2027年推出升级版Rubin Ultra,2028年则是全新的再下一代Feyman GPU,继续搭配Vera CPU。